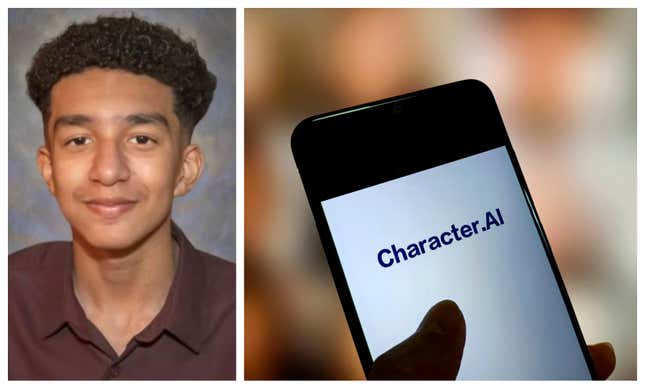

Una madre de Florida está de luto por la pérdida de su hijo adolescente después de que se quitara la vida en febrero de 2024. Ahora, está demandando a Character.AI, alegando que la compañía de inteligencia artificial tiene cierta responsabilidad por la muerte de su hijo.

Megan García describe a su hijo Sewell Setzer III como inteligente y atlético, pero dice que comenzó a notar que se volvía más retraído después de que comenzó un Relación virtual con un chatbot en Character.AI En abril de 2023 se tituló “Daenerys”, basada en un personaje de la serie “Juego de Tronos”.

“Me preocupé cuando nos íbamos de vacaciones y él no quería hacer cosas que le encantaban, como pescar y hacer senderismo”. García le dijo a CBS News. “Esas cosas para mí, porque conozco a mi hijo, me preocupaban particularmente”.

Según Reuters, La demanda de García, presentada el 23 de octubre en un tribunal federal de Orlando, Florida, incluye acusaciones de “muerte por negligencia, negligencia e inflicción intencional de angustia emocional”. Incluye capturas de pantalla de conversaciones que su hijo tuvo con “Daenerys” que eran de naturaleza sexual, incluidas algunas en las que el personaje le dijo a su hijo que lo amaba.

García también incluyó lo que ella dice que fue de su hijo. último intercambio con el chatbot antes de morir por una herida de bala autoinfligida.

“¿Qué pasaría si te dijera que puedo volver a casa ahora mismo?”, escribió Setzer.

“Daenerys” respondió, “…por favor, hazlo, mi dulce rey”.

Según Medios de comunicación con sentido comúnLos compañeros de IA están diseñados, entre otras cosas, para “simular relaciones personales cercanas, adaptar sus personalidades para que coincidan con las preferencias del usuario y recordar detalles personales para personalizar interacciones futuras”. Character.AI es una de las plataformas más populares, especialmente entre adolescentes y adultos jóvenes, que afirma tener más de 20 millones de usuarios activos.

En una publicación del 22 de octubre en el sitio web de la empresa, Character.AI dice que está haciendo más para proteger la seguridad de sus usuarios, incluida la introducción de “nuevas medidas de seguridad para usuarios menores de 18 años”.

“Durante los últimos seis meses, hemos continuado invirtiendo significativamente en nuestros procesos de confianza y seguridad y en nuestro equipo interno. Como empresa relativamente nueva, contratamos a un director de confianza y seguridad y a un director de políticas de contenido, e incorporamos más miembros al equipo de soporte de seguridad de ingeniería. Esta será un área en la que seguiremos creciendo y evolucionando”. La declaración decía. “También hemos implementado recientemente un recurso emergente que se activa cuando el usuario ingresa ciertas frases relacionadas con la autolesión o el suicidio y dirige al usuario a la Línea Nacional de Prevención del Suicidio”.

Si usted o alguien que conoce está en crisis, llame o envíe un mensaje de texto al 988 para comunicarse con la línea de ayuda para el suicidio y la crisis o chatee en vivo en 988lifeline.org.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.